Facebook最新の自社サーバとデータセンターの写真や仕様が満載、高度なサーバ効率化技術を公開する「Open Compute Project」開始

Facebookが独自に研究して培ってきたデータセンターやサーバ運用の最新テクノロジーの詳細な画像や仕様のドキュメントなどが満載の「Open Compute Project」がオープンしました。できるだけ低いコストで最も効率的なインフラストラクチャーを構築するためにソフトウェア・サーバ・データセンターを最初から最後まで独自に設計して構築するという手法を採用しています。

他のデータセンターよりも電力使用量は38%も効率化されており、コストは24%削減、変圧器損失についても今までは11~17%の損失だったものをわずか2%に抑えて効率化、しかも冷却のためのエアコンを廃止し、外気を取り入れて空調の配管なしで冷やすという方式。さらにサーバ用のシャーシも独自の設計となっており、CADファイルもダウンロード可能で、使用しているAMDとIntelのマザーボードなども仕様付きで公開、使用しているラックなども写真付きで公開しており、かなりすごいものになっています。

公開されている各種画像などの閲覧は以下から。

Open Compute Project

http://opencompute.org/

場所はオレゴン州のPrinevilleとなっており、このロケーション選定自体がデータセンターの電力性能を効率化させるための第一歩だそうです。

データセンターの設備は277VACのサーバ電源に統合された48VDCのUPSシステムを使用しています。

これがFacebookのデータセンター内部。

使用しているトリプレット・ラック

ずらっと並んでいます

青く光るのが美しいですが、これらはイーサネット経由で電力を供給されているLED照明となっています。また、この通路はサーバの発熱によってあたためられた空気が通って外へ出て行くという仕組みも兼ねています。

サーバの一群によって暖められた空気を移動させる通路に入るためのドア。冷却は受動的に行われるパッシブ・クーリング・インフラストラクチャーを採用、設備を動かし続ける際の消費エネルギーを可能な限り減らしています。

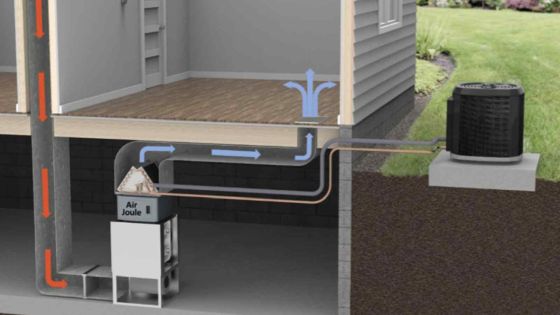

これがエアコンではない空調システム。ミストが蒸発する事で空気を冷却するシステムとなっており、適度な湿度も維持可能というのがポイント。これによってデータセンター設備のエネルギー効率を表す指標であるPUE(Power Usage Effectiveness:電力使用効率)はEPAに定義された最先端技術の業界平均である1.51よりもさらに下の1.073を達成しているとのこと。

空気を流す冷却部分。従来の中央に巨大な冷却システムを置くという方式ではなく、それに伴って従来のインラインによるUPSシステム・480Vを280Vに変換するシステムも削除しています。

暖められた空気を外へ排出するための巨大ファンたち

冷たい外気をデータセンターの中に取り入れる部分

外気を取り込む際のフィルター

データセンター全体の冷却のシステムはこうなっています。左から順に、まず外気を取り込み、次にミストを作り出すシステムを外気が通過して冷やされ、巨大なファンによって吸気されていきます。この部分にフィルターがあるので余計なダストは除去され、データセンターに冷たい空気が流れ込みます。データセンターの熱によってあたためられた空気の一部はさらに最初の外気の部分やフィルタールームまで戻されたり、そのまま外へ自然の気圧差やファンの働きで排出されたりする、という流れです。

Facebookの技術開発を行ったエレクトロニクス・ラボ

これが独自開発のシャーシに各部品を載せた状態。つまりこれがFacebookのサーバ。これをいくつも組み合わせているわけです。

AMDのマザーボード。

AMD Opteron 6100を2個搭載できるようになっており、DIMMスロットは24まで搭載可能。従来のマザーボードにあるべき多くの要素がそぎ落とされているベアボーン状態であり、これによって電力消費の削減とコストの削減を実現しています。

AMDのマザーボードにのっているヒートシンク

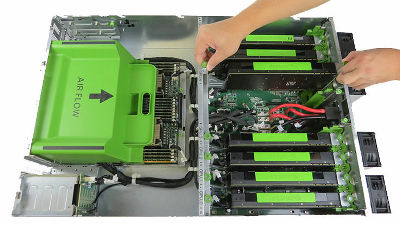

エアフローの流れ

Intelのマザーボード。

Intel Xeon 5500かIntel Xeon 5600を2個搭載できるようになっており、DIMMスロットは18まで搭載可能。AMDのマザーボードと同様に、従来のマザーボードにあるべき多くの要素がそぎ落とされているベアボーン状態であり、これによって電力消費の削減とコストの削減を実現しています。

エアフローの流れ

マザーボードをのせるとこうなります

中央の青い部分はバックアップ用のバッテリーを搭載したキャビネットラック

中身はこういう構造になっています

仕組みの解説図

このシャーシはカスタムされたマザーボードと電源を収納するためのもの。とがった角を極力無くし、ねじ止めも最小限にし、マザーボードの着脱が素早く行えるようになっており、ハードディスクもドライブベイへ滑るように着脱できるようにするためのスナップ・イン・レールが使用されています。

450Wの電源を使っており、AC/DC変換が可能で、単一の電圧は12.5VDCとなっており、クローズドなフレーム、これ単体で冷却機能を持っている高性能なものです。変換装置は独立したAC入力とDC出力のコネクタがあり、バックアップ電圧用のDC入力コネクタもあります。高い電力効率が優先されて設計されているのが特長だそうです。

電源の説明図

Facebookとしてはハードウェア的な仕様をオープンにする事によって、伝統的なオープンソースのソフトウェア開発と同じようにしてサーバやデータセンターの開発を行い、その第一歩として仕様書と設計図を今回は公開、さらにセカンドステップとしてコミュニティーとこれらの仕様を改善していきたいと考えており、これらの仕様を見てもらうことで、どこが悪い箇所なのかを示してもらい、そうすることでより効率的なデータセンターを作り上げたい、としています。

たとえばシャーシやラックなどについて、詳細がこのようにして公開されています。

・関連記事

マイクロソフトの考える屋根がない衝撃的な第4世代型データセンター構想 - GIGAZINE

映画に出てきそうな地下データセンター - GIGAZINE

Googleのデータセンターで火事、6台の消防車が出動して消火活動 - GIGAZINE

データセンターを箱に入れる「Project Blackbox」 - GIGAZINE

・関連コンテンツ

in ハードウェア, Posted by darkhorse

You can read the machine translated English article Facebook Completely equipped with the la….